Vad är stabil diffusion och hur man maximerar dess kraft

Artificiell intelligenss frammarsch tar nu över några program som kommer att hjälpa till att skapa bilder. Du kan se verktyget stabil diffusion. Men vad är stabil diffusion? Detta är ett bildgenererande verktyg. Dess primära syfte är att skapa bilder med hjälp av uppmaningar, och människor tycker att det är tilltalande och roligt att skapa olika karaktärer och element tillsammans. Lär dig mer om vad som är stabil diffusion och ta reda på hur det fungerar.

Guidelista

Del 1: Vad är stabil diffusion Del 2: Vad är VAE Stabil Diffusion Del 3: Vad är Dreambooth på stabil spridning och hur man installerar Del 4: Vad är CFG-skala i stabil diffusion Del 5: Vad är denoising Strength Stabil diffusion Del 6: Vad är Clip Skip Stable Diffusion och hur man använder Del 7: Vad är stabil diffusionsgenererande hastighet och hur man accelererar Del 8: Vanliga frågor om stabil diffusionDel 1: Vad är stabil diffusion

Det är en djupinlärning, text-till-bild-modell, som skapar bilder genom att mata in uppmaningar för att beskriva huvudämnet. Till exempel kan du sätta "katt" och verktyget genererar en bild av en katt. Det kan dock ytterligare betona eller lägga till fler detaljer när du anger komplexa uppmaningar. Det generativa neurala nätverket blir mer än ett AI-verktyg, eftersom det också är betingat med andra uppgifter som ommålning, målning och bild-till-bild-översättning via textuppmaningar.

Stable Diffusion utvecklades och finansierades av Stability AI, men CompVis-gruppen vid Ludwig Maximilian University of München har den tekniska licensen för den latenta diffusionsmodellen. Vidare leddes utvecklingen av forskarna Patrick Esser och Robin Rombach, som fick mer utbildningsdata från ideella organisationer i Tyskland som supportrar till projekten. Senare i oktober 2022 samlade företaget in US$101 miljoner efter att ha introducerat det i augusti 2022.

Del 2. Vad är VAE Stabil Diffusion

Du kanske har stött på detta när du använder AI-fotogeneratorn, och VAE är till hjälp för verktyget. VAE står för Variable Auto Encoder, som används för att finjustera dekodern för att måla bättre detaljer. Det är ett tillägg till AI-verktyget, eftersom det kan hjälpa till att få skarpare bilder och levande färger och förbättra genereringen av händer och ansikten.

Naturligtvis är VAE för mer än bara stabil spridning eftersom alla modeller har inbyggda VAE för att räkna ut detaljerna. Jämförelsen blir resultatet mellan varje modell och hur de kommer att bli när du komprimerar bilderna. Dessutom finns det separata VAE-filer som du kan ladda ner på din enhet. För att prova en avkodare kan du använda följande:

- Orangemix/något VAE för anime.

- Kl-f8-anime2 för anime.

- Vae-ft-mse-840000-ema-beskärs för realism eller målningar.

Del 3. Vad är Dreambooth på stabil spridning och hur man installerar

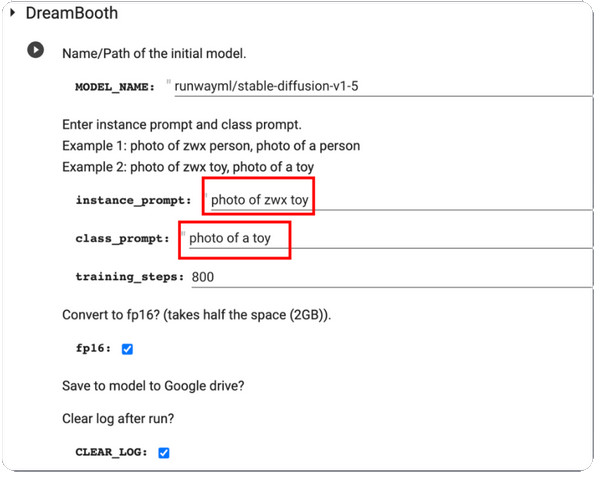

DreamBooth är en modell för djupinlärning som finjusterar genererade bilder, särskilt det specifika ämnet. Till en början är den baserad på Imagens text-till-bild-modell, men tyvärr har Imagen inte de förtränade vikterna som Stable Diffusion eller andra AI-verktyg. DreamBooth utvecklades vidare av Google Researchers och några kollegor från Boston University 2022.

Modellens arbete är att modifiera och finjustera genererade foton, men den kan också återge välbekanta motiv i alla miljöer och situationer. Eftersom de flesta förtränade diffusionsmodellerna fortfarande behöver förbättras i denna kategori kommer DreamBooth att öka utbildningen för diffusionsmodeller. Med bara fem bilder kan bildändringar göras med plattformar som Stable Diffusion. Här är en kort instruktion om hur du använder DreamBooth på stabil diffusion:

Steg 1.Först måste du ha träningsbilder av ett ämne att använda på DreamBooth. Se till att motivet har bilder tagna. Fortsätt för att ändra storlek på bilderna till 512x512 pixlar.

Steg 2.Öppna DreamBooth och gå in Instansprompt och Klassuppmaning. Bearbeta ändringarna genom att klicka på Spela knappen från den vänstra delen av gränssnittet.

Steg 3.När du är klar, testa det, och du kommer att få några prover som genereras av modellen. Du kan ladda ner modellkontrollpunktsfilen från din Google Drive och installera den i GUI.

Del 4. Vad är CFG-skala vid stabil diffusion

Du kan hitta det här värdet i fotogeneratormodellen. Och eftersom det är viktigt måste du lära dig vad som är värt att optimera bilder. Classifier Free Guidance Scale låter användarna justera närheten till resultatet från inmatningsbilden eller uppmaningar som används. Till exempel, när du justerar CFG-skalan till ett mer utmärkt värde, kommer utdata att likna ingångsbilden mer men förväntas bli förvrängd. Å andra sidan kommer en lägre CGF-skala att få utdata långt bort från den primära prompten samtidigt som den genererar bättre kvalitet.

Men när behöver man använda CFG-skalan på Stable Diffusion? Svaret är enkelt: AI-fotogeneratorn kan inte skapa något som inte ligger inom dess kunskap, så CFG-skalan hjälper dig att förena flera ämnen genom att höja dess värde. Den enda nackdelen är kostnaden för bildkvalitet, som är proportionell mot uppmaningarna. Om du är intresserad av det här verktyget måste du träna på att kalibrera vågen för att hitta sweet spot.

Del 5. Vad är denoising Styrka Stabil diffusion

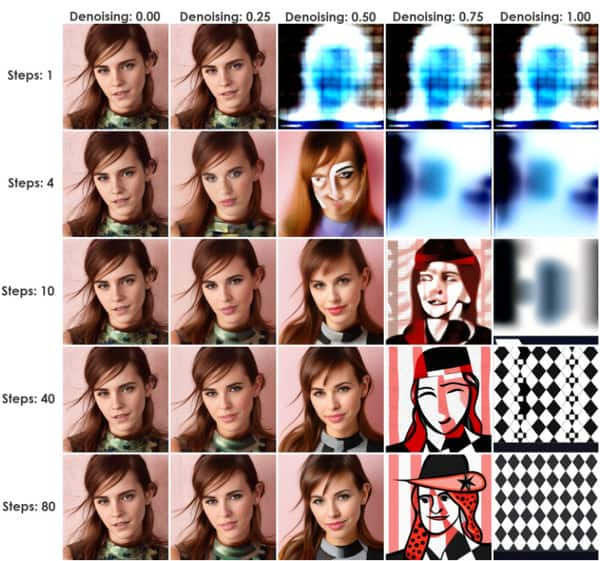

Denna metod initierar en process som lägger till brus till ingångsbilderna. Det är bara en Stabil Diffusionsuppskalare. Det är ett utmärkt värde för Stable Diffusion, eftersom det kan ta sig igenom bild-till-bild(img2img) eller InPaint. Brusmängden styrs av Denoise Strength, från ett minimum av 0 till ett maximum av 1. Om du sätter värdet till 0 kommer bruset att reduceras till inget, vilket gör en liknande bild som ingångsbilden. Annars kommer värdet 1 att ersätta ingången med brus.

Du kan använda Denoise Strength som en praktisk metod för att bestämma utgångens närhet till ingångsbildernas inflytande. Ett bra exempel är en lägre Denoising Strength som gör att genererade bilder ser närmare ingången, en idealisk inställning för mindre modifieringar. Å andra sidan kommer Higher Denoising Strength sannolikt att öka variationen samtidigt som likheten mellan ingångs- och utmatningsbilderna minskar. Därför är högre värden till hjälp för betydande modifieringar.

Del 6. Vad är Clip Skip Stable Diffusion och hur man använder

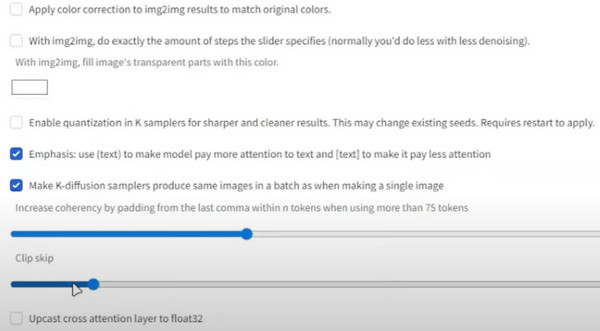

CLIP är känt som ett inbäddningslager som används för att analysera texter. Dess struktur är sammansatt av lager, som per individ är mer specifik än den föregående. Till exempel kan lager 1 vara "Person" och lager 2 kommer att vara "kvinna" eller "man". Sedan blir nästa lager "förälder, far, man, pojke, etc."

Dess syfte är att få den exakta textmodellen, som stoppar den långa listan av lager, så småningom blanda mer data och ge dig mer än du behöver. Det bästa exemplet på detta är 1,5-modellen med 12 graders djup. Varje lager har textinbäddning och kan blandas med andra detaljer, såsom storlek, färg, etc. CLIP hoppar över textutrymmesdimensionen och kommer till exakt utdata. Så här använder du det:

Steg 1.Från den stabila diffusionskontrollpunkten, gå till inställningar och välj "Stabil diffusion".

Steg 2.Scrolla ner och gå till "Clip Skip". Ställ in det till önskat värde och scrolla sedan uppåt för att klicka på knappen "Använd inställningar".

Del 7. Vad är stabil diffusionsgenererande hastighet och hur man accelererar

När du tittar på hastigheten på en AI-generator kommer du att förvänta dig att det kommer att ta lite tid att visa resultat. Stabil diffusion har dock en genereringshastighet på 10 sekunder. Detta är endast för allmän användning av onlineverktyget, men tiden kan fortfarande minska upp till fyra sekunder när du prenumererar på den primära eller standardplanen. Detta är ett sätt att accelerera modellens hastighet, men resultatets noggrannhet glider bort från ingången Stabil diffusionsmeddelande. Dessutom är verktyget gratis med endast ett fåtal funktionsbegränsningar från de prissatta planerna. Så, hur accelererar du genereringshastigheten utan att betala?

Det enda kravet för acceleration är ett Nvidia-kort, som kan vara i 4000-, 3000-, 2000- och till och med 1000-serien. Du kan använda Lovelace, Ampere, Pascal Turing, etc. Som ett alternativ, använd en lägre precision som float16 och kör färre inferenssteg.

Bonustips: Ändra storleken på stabila diffusionsresultat

Efter att ha lärt dig om AI-modellen finns det en sak till som du måste veta: filstorleken är en enorm faktor för bilder, och de kan äta upp ditt lagringsutrymme på grund av större filstorlekar. Men med AnyRec gratis bildkompressor online, kommer det att vara bekvämt att komprimera bilderna. Onlineverktyget har den senaste AI-tekniken för att hjälpa till att optimera uppladdningarna och samtidigt minska filstorleken. Eftersom det genererar mindre filer kan användaren importera fler bilder från den lokala mappen och kompressorn laddar dem direkt.

- Komprimera bilder genererade med stabil diffusion med kvalitet.

- Har ingen vattenstämpel på de komprimerade bilderna.

- Stöd för format som JPEG, GIF, TIFF, BMP, PNG och mer.

- Fixa automatiskt de förvrängda, suddiga och fyll upp nya pixlar i bilden.

Del 8. Vanliga frågor om stabil diffusion

-

1. Kan jag använda Stable Diffusion offline?

Ja. verktyget kan användas utan internetanslutning. Detta beror på att den kan lagra syntetiska data lokalt, vilket ger AI-modellerna träning för att vänja sig utan ett internetnätverk.

-

2. Vilka är nackdelarna med AI-fotogeneratorn?

Förutom dess fördelar kan verktyget vara beräkningsintensivt, samtidigt som det tar tid när man hanterar foton och videor med mer omfattande data. En annan är att kvaliteten beror på indata och nätverksparametrar som används. Det betyder att det inte finns någon garanti för att du får en bild av hög kvalitet.

-

3. Behöver jag avancerad utrustning när jag använder Stable Diffusion?

Nej. Fotogeneratorn kan användas utan den senaste datorversionen. Även om du har den senare versionen räcker det med att använda AI-generatorn.

-

4. Var får man textuppmaningar?

Stable Diffusion har en inbyggd textprompttekniker som hjälper dig att söka efter prompter. Skriv bara in en text och klicka på knappen Sök. Resultaten visas på några sekunder med bilder som exempel.

-

5. Vilken GPU behöver jag för att köra onlineverktyget?

Eftersom den stöder de flesta GPU:er kan du köra AI-bildgeneratorn med Nvidia och AMD på 6 GB

Slutsats

Det här inlägget förklarar vad är stabil diffusion och hur det fungerar med Clip Skip, VAE, DreamBooth, CFG Scale och Denoising Strength. Å andra sidan kan du använda AnyRec Free Image Compressor Online för att minska filstorlekarna på de genererade bilderna. Det är helt gratis och obegränsat att använda!